Разделы

Счетчики

Базовые знания по нейроподобным сетям

Рассматривается что такое нейроподобная сеть и модели нейронных сетей.

Содержание

Введение в нейроподобные сети

- Два основных направления в исследованиях по искусственному интеллекту

- Что такое нейроподобная сеть

- Каким образом нейроподобная сеть способна решить нетривиальную задачу

- Оценки… Выводы… Прогнозы

Два основных направления в исследованиях по искусственному интеллекту

Искусственный интеллект как научное направление, связанное с попытками формализовать мышление человека, имеет длительную предысторию. Первые шаги кибернетики были направлены на изучение и осмысление в новых понятиях процессов, протекающих в сложных, прежде всего живых, системах, включая и мыслящие. Позднее это направление работ оформилось в самостоятельную область, разрабатывающую проблему искусственного интеллекта.

В ходе последующего развития исследований по искусственному интеллекту произошло их разделение на относительно самостоятельных направления. Это разделение сохраняется и до сегодняшнего дня.

Разделение работ по искусственному интеллекту на два направления связано с существованием двух точек зрения на вопрос, каким образом строить системы искусственного интеллекта. Сторонники одной точки зрения убеждены, что «важнее всего результат», т.е. хорошее совпадение поведения искусственно созданных и естественных интеллектуальных систем, а что касается внутренних механизмов формирования поведения, то разработчик искусственного интеллекта вовсе не должен копировать или даже учитывать особенности естественных, живых аналогов.

Другая точка зрения состоит в том, что именно изучение механизмов естественного мышления и анализ данных о способах формирования разумного поведения человека могут создать основу для построения систем искусственного интеллекта, причем построение это должно осуществляться прежде всего как моделирование, воспроизведение техническими средствами принципов и конкретных особенностей функционирования биологических объектов.

Первое направление, таким образом, рассматривает продукт интеллектуальной деятельности человека, изучает его структуру, и стремиться воспроизвести этот продукт средствами современной техники. Ясно, что успехи этого направления искусственного интеллекта оказываются тесно связанны с развитием возможностей ЭВМ и искусства программирования, т.е. с тем комплексом научно-технических исследований, которые часто называют компьютерными науками. В связи со сказанным это направление искусственного интеллекта можно охарактеризовать термином «машинный интеллект».

Второе направление искусственного интеллекта рассматривает данные о нейрофизиологических и психологических механизмах интеллектуальной деятельности и, в более широком плане, разумного поведения человека. Оно стремиться воспроизвести эти механизмы с помощью тех или иных технических устройств, с тем чтобы «поведение» таких устройств хорошо совпадало с поведением человека в определенных, заранее задаваемых пределах. Развитие этого направления тесно связано с успехами наук о человеке. Для него характерно стремление к воспроизведению более широкого, чем в машинном интеллекте, спектра проявлений разумной деятельности человека. Сказанное позволяет охарактеризовать данное направление искусственного интеллекта термином «искусственный разум».

Оба основных направления искусственного интеллекта связаны с моделированием, но в случае машинного интеллекта мы имеем дело с моделированием феноменологическим, имитационным, а в случае искусственного разума – с моделированием структурным.

Что такое нейроподобная сеть

На компьютерном рынке России, перенасыщенном вычислительными средствами традиционной однопроцессорной архитектуры фон Неймана, появился новый вид программно-аппаратных изделий, которые реализуют параллельную распределенную обработку информации, аналогичную мыслительной деятельности высокоорганизованных живых существ. Речь идет о нейроподобных сетях (НПС) и различных видах их реализации: нейропакетах, нейроплатах и нейрокомпьютерах (НК).

Современные цифровые вычислительные машины способны с высоким быстродействием и точностью решать формализованные задачи с вполне определенными данными по заранее известным алгоритмам. Однако в тех случаях, когда задача не поддается формализации, а входные данные неполны, зашумлены или противоречивы, применение традиционных компьютеров становится неэффективным. Альтернативой им становятся специализированные компьютеры, реализующие нетрадиционные нейросетевые технологии. Сильной стороной этих комплексов является нестандартный характер обработки информации. Она кодируется и запоминается не в отдельных ячейках памяти, а в распределении связей между нейронами и в их силе, поэтому состояние каждого отдельного нейрона определяется состоянием многих других нейронов, связанных с ним. Следовательно, потеря одной или нескольких связей не оказывает существенного влияния на результат работы системы в целом, что обеспечивает ее высокую надежность.

Высокая «естественная» помехоустойчивость и функциональная надежность касаются как искаженных (зашумленных) потоков информации, так и в смысле отказов отдельных процессорных элементов. Этим обеспечиваются высокая оперативность и достоверность обработки информации, а простая дообучаемость и переобучаемость НПС позволяют при изменении внешних факторов своевременно осуществлять переход на новые виды решаемых задач.

Приведенные выше преимущества нейросетевой обработки данных определяют области применения НПС:

- обработка и анализ изображений;

- распознавание речи независимо от диктора, перевод;

- обработка высокоскоростных цифровых потоков;

- автоматизированная система быстрого поиска информации;

- классификация информации в реальном масштабе времени;

- планирование применения сил и средств в больших масштабах;

- решение трудоемких задач оптимизации;

- адаптивное управление и предсказание.

Во многих зарубежных странах, где нейрокомпьютеры и нейроплаты не являются невиданной экзотикой, их уже сегодня активно применяют военные и медики, финансовые брокеры и налоговые инспекторы, специалисты по обработке изображений и представители многих других профессий. Таможенники используют нейроплаты для обнаружения пластиковых бомб и наркотиков, финансисты — для предсказания курсов валют, летчики — для распознавания наземных целей, банкиры — для оценки кредитных рисков...

Основные положения теории деятельности головного мозга и математическая модель нейрона были разработаны У. Маккалоком и Ч. Питтсом в 1943 году и опубликованы в статье «Логическое исчисление идей, относящихся к нервной деятельности», которая была издана на русском языке в сборнике «Автоматы» только спустя 13 лет. Согласно предложенной модели мозг представляет собой ансамбль нейронов, имеющих одинаковую структуру. Каждый нейрон реализует некоторую функцию, называемую пороговой, над входными значениями. Если значение функции превышает определенную величину - порог (что характеризует суммарную значимость полученной нейроном информации), нейрон возбуждается и формирует выходной сигнал для передачи его другим нейронам. Пройдя путь от рецепторов (слуховых, зрительных и других) через нейронные структуры мозга до исполнительных органов, входная информация преобразуется в набор управляющих воздействий, адекватных ситуации.

Отдельные нейроны, соединяясь между собой, образуют новое качество, которое, в зависимости от характера межнейронных соединений, имеет различные уровни биологического моделирования:

- группа нейронов;

- нейронная сеть;

- нервная система;

- мыслительная деятельность;

- мозг.

Теперь мы подошли к тому моменту, когда необходимо дать ряд определений, характеризующих рассматриваемую предметную область.

Нейроподобная сеть — это параллельная связная сеть простых адаптивных элементов, которая взаимодействует с объектами реального мира аналогично биологической нервной системе. С инженерной точки зрения такая сеть представляет собой сильно распараллеленную динамическую систему с топологией направленного графа, которая может выполнять переработку информации посредством изменения своего состояния в ответ на постоянный или импульсный входной сигнал.

В настоящее время основными направлениями реализации НПС являются:

- программная реализация на цифровых ЭВМ традиционной архитектуры;

- программно-аппаратная реализация в виде сопроцессоров к ЭВМ общего назначения;

- аппаратная реализация путем создания нейрокомпьютеров на базе нейроплат в виде параллельных нейроподобных структур.

Ранние варианты реализации НПС относятся к первым двум из указанных направлений. Первое направление характеризуется универсальностью, дешевизной и низкой скоростью обучения и функционирования НПС. Для второго направления характерна высокая скорость моделирования функционирования НПС, но при этом существуют серьезные физические ограничения числа моделируемых элементов и связей между ними, а также возможностей обучения и до обучения. По мере развития элементной базы ЭВМ стало возможным самостоятельное развитие третьего направления, которое положило начало индустрии нейрокомпьютеров, представляющих совокупность аппаратных и программных средств для реализации моделей нейронных сетей.

На сегодняшний день известно уже более 200 различных парадигм нейронных сетей (не только детерминированных, но и вероятностных), десятки НПС реализованы в специализированных кристаллах и платах, на их основе созданы мощные рабочие станции и даже суперкомпьютеры.

Каким образом нейроподобная сеть способна решить нетривиальную задачу

Как известно, для решения неформализованных задач традиционно применяются два основных подхода. Первый, основанный на правилах, характерен для хорошо известных и уже зарекомендовавших себя экспертных систем. Второй, основанный на примерах, представляет собой классический случай применения нейросетевой технологии: от пользователя не требуется знания каких бы то ни было правил, как в экспертных системах; надо лишь иметь достаточное количество примеров для настройки адаптивной системы с заданной степенью достоверности:

Процесс обучения НПС новому классу задач включает следующие стадии:

- Формулируется постановка задачи и выделяется набор ключевых параметров, характеризующих предметную область.

- Выбирается парадигма нейронной сети (модель, включающая в себя вид входных данных, пороговой функции, структуры сети и алгоритмов обучения), наиболее подходящая для решения данного класса задач. Как правило, современные нейропакеты, нейроплаты и нейрокомпьютеры позволяют реализовать не одну, а несколько базовых парадигм.

- Подготавливается возможно более широкий набор обучающих примеров, организованных в виде наборов входных данных, ассоциированных с известными выходными значениями. Входные значения для обучения могут быть неполны и частично противоречивы.

- Входные данные по очереди предъявляются НПС, а полученное выходное значение сравнивается с эталоном. Затем производится подстройка весовых коэффициентов межнейронных соединений для минимизации ошибки между реальным и желаемым выходом сети.

- Обучение повторяется до тех пор, пока суммарная ошибка во всем множестве входных значений не достигнет приемлемого уровня либо НПС не придет в стационарное состояние. Рассмотренный метод обучения нейроподобной сети носит название «обратное распространение ошибки» (error backpropagation) и относится к числу классических алгоритмов нейроматематики.

Настроенная и обученная НПС может использоваться на реальных входных данных, не только подсказывая пользователю корректное решение, но и оценивая степень его достоверности. Рассмотрим более подробно современные возможности реализации НПС в программно-аппаратных изделиях и используемую элементную базу.

Оценки… Выводы… Прогнозы

Современные возможности аппаратной реализации НПС можно обобщенно оценить следующим образом:

- число моделируемых нейронов — до 5 млн.;

- число моделируемых связей — до 5 млн.;

- скорость моделирования — до 500 млн. переключений связей/с.

Для аппаратной реализации НПС в настоящее время широко используются процессорные СБИС, обладающие максимальными коммуникационными возможностями и ориентированные на быстрое выполнение векторных операций. К таким СБИС относятся транспьютеры фирмы INMOS (Т414, Т800, А100), сигнальные процессоры фирм Texas Instruments (TMS 320С40, TMS 320C80), Motorola, Analog Device. Отечественная элементная база представлена нейрочипами на базе БМК «Исполин - бОТ».

На современном этапе развития технологии микроэлектроники и других смежных областей нейронная технология стала адекватна не только различным типам микроэлектронной полупроводниковой технологии, но и оптической, оптоэлектронной, молекулярной, квантовой и некоторым другим.

Необходимо отметить, что рождение технологии систем на пластине и нанотехнологии приведет к рождению новых сверхпараллельных архитектур. Уже сейчас ясна адекватность нейросетевых архитектур технологии на пластине. Поэтому любые попытки на уровне наноэлементов делать функциональные блоки со старой архитектурой, адекватной однопроцессорным машинам, должны окончиться неудачей.

Современные технологии достигли того рубежа, когда стало возможным изготовление технической системы из 3...4 млрд. нейронов (именно такое количество их в мозгу человека). Однако их соединение продолжает оставаться проблемой.

Перечислим основные направления вычислительной техники:

- однопроцессорные ЭВМ (персональные ЭВМ, ЭВМ среднего класса);

- малопроцессорные ЭВМ;

- многопроцессорные ЭВМ (ЭВМ с массовым параллелизмом, транспьютерная ЭВМ, псевдотранспьютерная ЭВМ, ЭВМ с транспьютерным ядром и периферийными процессорами типа i860, Power PC, Alfa, Рб);

- нейрокомпьютеры.

Приоритет российской вычислительной науки и техники в указанных направлениях в ближайшие годы максимально может быть проявлен именно в области НК, поскольку она является максимально наукоемкой и менее других зависит от технологического уровня.

В России высок уровень теоретических работ и экспериментальных исследований по нейросистемам и нейроинформатике. Удачно выбрана форма взаимодействия между организациями через координацию НЦН РАН. Это говорит о том, что все необходимые компоненты для технологического рывка в нашей стране существуют.

Реальность создания нейрокомпьютерных средств уже сегодня не вызывает сомнений. Это кредиторам дает дополнительный стимул для вложения средств в развитие теоретических исследований, направленных на поиск решений широкого круга практических задач на основе нейросетевых технологий.

Основы теории нейроподобных сетей

- Некоторые сведения о мозге

- Нейрон

- О строении мозга

- О моделировании нейронных сетей

- Нейроподобная сеть

- Обучение нейроподобной сети

- Методы исследования нейроподобных сетей

Некоторые сведения о мозге

Мозг является, пожалуй, самой сложной из известных нам систем переработки информации. Достаточно сказать, что в нем содержится около 100 миллиардов нейронов, каждый из которых имеет в среднем 10 000 связей. При этом мозг чрезвычайно надежен: ежедневно погибает большое количество нейронов, а мозг продолжает функционировать. Обработка огромных объемов информации осуществляется мозгом очень быстро, за доли секунды, несмотря на то, что нейрон является медленнодействующим элементом со временем реакции не менее нескольких миллисекунд.

Пока не слишком понятно, как мозгу удается получить столь впечатляющее сочетание надежности и быстродействия. Довольно хорошо изучена структура и функции отдельных нейронов, имеются данные об организации внутренних и внешних связей между нейронами некоторых структурных образований мозга, совсем мало известно об участии различных структур в процессах переработки информации.

Ниже приводятся некоторые сведения об устройстве и работе нервной системы, которые используются при построении моделей нейронных сетей.

Нейрон

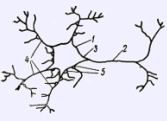

Нервные клетки, или нейроны, представляют собой особый вид клеток в живых организмах, обладающих электрической активностью, основное назначение которых заключается в оперативном управлении организмом. Схематическое изображение нейрона приведено на рисунке.

Нейрон имеет тело (сому) 1, дерево входов (дендриты) 4 и выходов (аксон и его окончания) 2. Сома, как правило, имеет поперечный размер в несколько десятков микрон. Длина дендритов может достигать 1 мм, дендриты сильно ветвятся, пронизывая сравнительно большое пространство в окрестности нейрона. Длина аксона может достигать сотен миллиметров. Начальный сегмент аксона 3, прилегающий к телу клетки, утолщен. Иногда этот сегмент называют аксонным холмиком. По мере удаления от клетки он постепенно сужается и на расстоянии нескольких десятков микрон на нем появляется миэлиновая оболочка, имеющая высокое электрическое сопротивление. На соме и на дендритах располагаются окончания (коллатерали) аксонов, идущих от других нервных клеток. Каждое такое окончание J имеет вид утолщения, называемого синаптической бляшкой, или синапсом. Поперечные размеры синапса, как правило, не превышают нескольких микрон, чаще всего эти размеры составляют около 1 мкм.

Входные сигналы дендритного дерева (постсинаптические потенциалы) взвешиваются и суммируются на пути к аксонному холмику, где генерируется выходной импульс (спайк) или пачка импульсов. Его наличие (или интенсивность), следовательно, является функцией взвешенной суммы входных сигналов. Выходной сигнал проходит по ветвям аксона и достигает синапсов, которые соединяют аксоны с дендритными деревьями других нейронов. Через синапсы сигнал трансформируется в новый входной сигнал для смежных нейронов. Этот входной сигнал может быть положительным и отрицательным (возбуждающим или тормозящим) в зависимости от вида синапсов.

Величина входного сигнала, генерируемого синапсом, может быть различной даже при одинаковой величине сигнала, приходящего в синапс. Эти различия определяются эффективностью или весом синапса. Синаптический вес может изменяться в процессе функционирования синапса. Многие ученые считают такое изменение нейрофизиологическим коррелятом (следом) памяти. При этом роль механизмов молекулярной памяти заключается в долговременном закреплении этих следов.

Нейроны можно разбить на три большие группы: рецепторные, промежуточные и эффекторные.

Рецепторные нейроны обеспечивают ввод в мозг сенсорной информации. Они трансформируют сигналы, поступающие на органы чувств (оптические сигналы в сетчатке глаза, акустические в ушной улитке или обонятельные в хеморецепторах носа), в электрическую импульсацию своих аксонов. Эффекторные нейроны передают приходящие на них сигналы исполнительным органам. На конце их аксонов имеются специальные синаптические соединения с исполнительными органами, например мышцами, где возбуждение нейронов трансформируется в сокращения мышц. Промежуточные нейроны осуществляют обработку информации, получаемой от рецепторов, и формируют управляющие сигналы для эффекторов. Они образуют центральную нервную систему.

О строении мозга

Головной мозг человека и высших животных состоит из серого и белого вещества. Серое вещество представляет собой сеть дендритов, аксонов и тел нервных клеток. Миэлинизированные волокна, соединяющие различные области мозга друг с другом, с органами чувств и мускулами, образуют белое вещество.

В мозге существуют структурно обособленные отделы, такие, как кора, гиппокамп, таламус, мозжечок, миндалина, полосатое тело и т. д. Каждый из отделов, в свою очередь, имеет сложное модульное строение. Особое место в мозге зажимает церебральная кора. Она образует поверхность мозга, она также является его новейшей частью. Считается, что именно здесь происходят важнейшие процессы ассоциативной переработки информации.

О моделировании нейронных сетей

Уровни моделирования и терминология

Моделирование функций нервной системы производится на разных уровнях организации и абстракции. Можно выделить следующие категории моделей: отдельных нейронов, небольших групп нейронов, нейронных сетей, нервной системы, мыслительной деятельности и мозга в целом. Далее будем рассматривать модели уровня нейронных сетей, состоящие из большого количества взаимосвязанных моделей нейронов. При этом акцент делается не на тщательной имитации свойств нейрона с целью исследования его динамических и адаптивных характеристик (как это имеет место на уровне моделирования отдельных нейронов), а на коллективных эффектах, возникающих при объединении большого числа нейроподобных элементов. Основная роль здесь отводится структуре межнейронных связей, что позволяет использовать простые модели нейронов и моделировать достаточно большие сети.

В дальнейшем при рассмотрении различных моделей нейронных сетей мы будем, придерживаясь терминологии различных авторов, называть их также «искусственные нейронные сети», «нейроподобные сети» или просто «нейронные сети». Модель нейрона принято называть также «нейроподобный элемент», «искусственный нейрон», «блок», «узел» или просто «нейрон».

Нейроподобный элемент

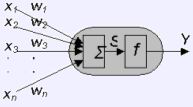

Нейроподобный элемент, который обычно используется при моделировании нейронных сетей, приведен на рисунке ниже.

На нейроподобный элемент поступает набор входных сигналов x1 ... хм (или входной вектор ), представляющий собой выходные сигналы других нейроподобных элементов. Этот входной вектор соответствует сигналам, поступающим в синапсы биологических нейронов. Каждый входной сигнал умножается на соответствующий вес связи w1…wm -аналог эффективности синапса. Вес связи является скалярной величиной, положительной для возбуждающих и отрицательной для тормозящих связей. Взвешенные весами связей входные сигналы поступают на блок суммации, соответствующий телу клетки, где осуществляется их алгебраическая суммация и определяется уровень возбуждения нейроподобного элемента S:

S=Σwixi; (1)

Выходной сигнал нейрона у определяется путем пропускания уровня возбуждения S через нелинейную функцию f:

y=f(s-Θ); (2)

где:

Θ - некоторое постоянное смещение (аналог порога нейрона).

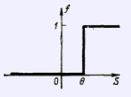

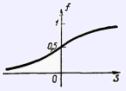

Обычно используются простейшие нелинейные функции:

бинарная

y={1 при S>Θ; 0 при S<Θ}; (3)

или сигмоидная:

y=1/e-(S-Θ); (4)

В такой модели нейрона пренебрегают многими известными характеристиками биологического прототипа, которые некоторые исследователи считают критическими. Например, в ней не учитывают нелинейность пространственно-временной суммации, которая особенно проявляется для сигналов, приходящих по возбуждающим и тормозящим синапсам, различного рода временные задержки, эффекты синхронизации и частотной модуляции, рефрактерность и т. п. Несмотря на это нейроподобные сети, простроенные на основе таких простых нейроподобных элементов, демонстрируют ассоциативные свойства, напоминающие свойства биологических систем.

Нейроподобная сеть

Нейроподобная сеть представляет собой совокупность нейроподобных элементов, определенным образом соединенных друг с другом и с внешней средой. Входной вектор (кодирующий входное воздействие или образ внешней среды) подается на сеть путем активации входных нейроподобных элементов. Множество выходных сигналов нейронов сети y1…ум называют вектором выходной активности, или паттерном активности нейронной сети. Веса связей нейронов сети удобно представлять в виде матрицы W, где Wij - вес связи между i- и j-м нейронами. В процессе функционирования (эволюции состояния) сети осуществляется преобразование входного вектора в выходной, т. е. некоторая переработка информации, которую можно интерпретировать, например, как функцию гетеро- или авто- ассоциативной памяти.

Конкретный вид выполняемого сетью преобразования информации обусловливается не только характеристиками нейроподобных элементов, но и особенностями ее архитектуры, т. е. той или иной топологией межнейронных связей, выбором определенных подмножеств нейроподобных элементов для ввода и вывода информации, наличием или отсутствием конкуренции, направлением и способами управления и синхронизации информационных потоков между нейронами и т. д.

Обучение нейроподобной сети

Одно из важнейших свойств нейроподобной сети - способность к самоорганизации, самоадаптации с целью улучшения качества функционирования. Это достигается обучением сети, алгоритм которого задается набором обучающих правил. Обучающие правила определяют, каким образом изменяются связи в ответ на входное воздействие. Многие из них являются развитием высказанной Д. О. Хеббом идеи о том, что обучение основано на увеличении силы связи (синаптического веса) между одновременно активными нейронами. Таким образом, часто используемые в сети связи усиливаются, что объясняет феномен обучения путем повторения и привыкания. Математически это правило можно записать следующим образом:

wij(t+1)=wij(t)+ayi*yj; (5)

где:

wij(t) и wij(t+1) - значение веса связи от i-го к j-му нейрону соответственно до и после его изменения;

a - скорость обучения.

В настоящее время существует множество разнообразных обучающих правил (алгоритмов обучения). Некоторые из них будут представлены в параграфах, посвященных рассмотрению конкретных нейросетевых моделей.

Методы исследования нейроподобных сетей

Для исследования построенной модели сети (с заданными характеристиками элементов, архитектурой и обучающими правилами) применяют три основных метода: аналитическое исследование, а также математическое (имитационное) и физическое моделирование. Сложность аналитического исследования рассматриваемых нами моделей с коллективным поведением обусловлена наличием большого числа взаимодействующих нелинейных нейроподобных элементов. Несмотря на это интересные аналитические результаты получены для многих из рассматриваемых далее моделей нейронных сетей, что в значительной степени способствовало их популярности.

Физическое моделирование позволяет быстро получать достоверные результаты работы модели, однако связано с технической сложностью аппаратной реализации большого количества нейроподобных элементов со многими адаптивными связями.

Математическое моделирование на универсальных ЭВМ дает возможность создать практически любые модели нейронных сетей, однако из-за последовательного характера их работы в обозримое время удается исследовать модели ограниченного размера. В настоящее время существуют и продолжают создаваться специальные вычислительные средства для эффективного моделирования больших нейроподобных сетей, а также реализованные в виде микросхем очень быстродействующие аппаратные модели небольших нейросетей.

Модели нейронных сетей

- Сети с прямыми связями

- Сети с симметричными связями

Сети с прямыми связями

1. Простой персептрон.

В середине 50-х годов была предложена одна из первых моделей нейронных сетей, которая вызвала большой интерес из-за своей способности обучаться распознаванию простых образов. Эта модель - персептрон - состоит из бинарных нейроподобных элементов и имеет простую топологию, что позволило достаточно полно проанализировать ее работу и создать многочисленные физические реализации.

Типичный персептрон состоит из трех основных компонент:

- матрицы бинарных входов r1..rn (сенсорных нейронов или «сетчатки», куда подаются входные образы);

- набора бинарных нейроподобных элементов xi… хм (или предикатов в наиболее общем случае) с фиксированными связями к подмножествам сетчатки («детекторы признаков»);

- бинарного нейроподобного элемента с модифицируемыми связями к этим предикатам («решающий элемент»).

На самом деле число решающих элементов выбирают равным количеству классов, на которое необходимо разбить предъявляемые персептрону образы.

Таким образом, модель персептрона характеризуется наличием только прямых связей, один из слоев которых является модифицируемым. В простейшем случае, когда п = m и xi == ri, детекторы признаков могут рассматриваться как входной слой. Тогда персептрон становится одним бинарным нейроподобным элементом. Это классическая модель М -входового нейрона, приведенная на рисунке, или простой персептрон Розенблатта. В общем случае каждый элемент xi может рассматриваться как булева функция, зависящая от некоторого фиксированного подмножества сетчатки. Тогда величина выходных сигналов этих обрабатывающих элементов является значением функции xi, которое равно 0 или 1.

Устройство реагирует на входной вектор генерацией выходного сигнала у решающего элемента по формуле (3). Таким образом, персептрон формирует гиперплоскость, которая делит многомерное пространство x1... хм на две части и определяет, в какой из них находится входной образ, выполняя, таким образом, его классификацию. Возникает вопрос, как определить значения весов, чтобы обеспечить решение персептроном конкретной задачи. Это достигается в процессе обучения.

Предложены различные правила обучения персептрона. Один из алгоритмов называется процедурой сходимости персептрона Розенблатта и является вариантом хеббовского правила изменения весов связей с учителем.

Алгоритм работает следующим образом. Вектор весов устанавливают в произвольное состояние. На сетчатку поочередно подают образы из обучающей выборки, которые трансформируются в выходной сигнал у решающего элемента. При правильном отклике ничего не изменяют. При неправильном отклике у = 0 веса всех связей от активных элементов сетчатки увеличивают, а при неправильном отклике у = 1 - уменьшают. Величина изменения связи определяет степень адаптации. Если решение существует, оно будет достигнуто при циклической подаче образов обучающей выборки за конечное число шагов при любом начальном выборе связей.

Таким образом, если два класса образов могут быть разделены гиперплоскостью, то при достаточно долгом обучении персептрон будет различать их правильно. Однако линейная разделяющая поверхность, упрощающая анализ персептрона, ограничивает решаемый им круг задач. Этот вопрос тщательно исследовали Минский и Пейперт, показав, какие задачи в принципе не может решить персептрон с одним слоем обучаемых связей. Одним из таких примеров является выполнение логической операции «исключающее ИЛИ».

2. Многослойный персептрон.

Как отмечалось выше, простой персептрон с одним слоем обучаемых связей формирует границы областей решений в виде гиперплоскостей. Двухслойный персептрон может выполнять операцию логического «И» над полупространствами, образованными гиперплоскостями первого слоя весов. Это позволяет формировать любые, возможно неограниченные, выпуклые области в пространстве входных сигналов. С помощью трехслойного персептрона, комбинируя логическими «ИЛИ» нужные выпуклые области, можно получить уже области решений произвольной формы и сложности, в том числе невыпуклые и несвязные. То, что многослойные персептроны с достаточным множеством внутренних нейроподобных элементов и соответствующей матрицей связей в принципе способны осуществлять любое отображение вход-выход, отмечали еще Минский и Пейперт, однако они сомневались в том, что можно открыть для них мощный аналог процедуры обучения простого персептрона.

В настоящее время в результате возрождения интереса к многослойным сетям предложено несколько таких процедур.

В данном параграфе описана детерминированная версия, получившая название « error back propagation» - алгоритм обратного распространения ошибки. Этот алгоритм является обобщением одной из процедур обучения простого персептрона, известной как правило Уидроу - Хоффа (или дельта-правило), и требует представления обучающей выборки. Выборка состоит из набора пар образов, между которыми надо установить соответствие, и может рассматриваться как обширное задание векторной функции, область определения которой - набор входных образов, а множество значений - набор выходов.

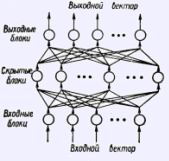

Рассмотрим многослойную нейроподобную сеть с прямыми связями (см. рисунок). Входные элементы (блоки) образуют нижний слой сети, выходные - верхний. Между ними может быть много слоев скрытых блоков. Каждый блок может быть соединен модифицируемой связью с любым блоком соседних слоев, но между блоками одного слоя связей нет. Каждый блок может посылать выходной сигнал только р вышележащие слои и принимать входные сигналы только от нижележащих слоев. Входной вектор подается на нижний слой, а выходной вектор определяется путем поочередного вычисления уровней активности элементов каждого слоя (снизу - вверх) с использованием уже известных значений активности элементов предшествующих слоев. С точки зрения распознавания образов входной вектор соответствует набору признаков, а выходной - классу образов. Скрытый слой используется для представления области знаний.

Перед началом обучения связям присваиваются небольшие случайные значения. Каждая итерация процедуры состоит из двух фаз. Во время первой фазы на сеть подается входной вектор путем установки в нужное состояние входных элементов. Затем входные сигналы распространяются по сети, порождая некоторый выходной вектор. Для работы алгоритма требуется, чтобы характеристика вход-выход нейроподобных элементов была неубывающей и имела ограниченную производную. Обычно для этого используют сигмоидную нелинейность вида (4).

Полученный выходной вектор сравнивается с требуемым. Если они совпадают, обучение не происходит. В противном случае вычисляется разница между фактическими и требуемыми выходными значениями, которая передается последовательно от выходного слоя к входному. На основании этой информации об ошибке производится модификация связей в соответствии с обобщенным дельта правилом, которое имеет вид:

Δpwij=ηδjpyip; (6)

где изменение в силе связи wij для р-й обучающей пары пропорционально произведению сигнала ошибки д j-го блока, получающего входной сигнал по этой связи, и выходного сигнала блока i, посылающего сигнал по этой связи. Определение сигнала ошибки является рекурсивным процессом, который начинается с выходных блоков.

Для выходного блока сигнал ошибки:

δjp=yj'(djp-0jp); (7)

где djp и ojp - желаемое и действительное значения выходного сигнала j-го блока; уj' - производная нелинейности блока.

Сигнал ошибки для скрытого блока определяется рекурсивно через сигнал ошибки блоков, с которым соединен его выход, и веса этих связей:

δjp=yj'Δδkpwki; (8)

Для используемой сигмоидной нелинейности уj' = уj (1 - уj), поэтому для 0 уj 1 производная максимальна при уj == 0,5 и равна нулю при уj =0 или 1. Соответственно веса изменяются максимально для блоков, которые еще не выбрали свое состояние. Кроме того, при конечных весах выходные сигналы блоков не могут достигать значений 0 или 1, Поэтому за 0 обычно принимают значения уj < 0.1, а за 1 - значения уj > 0.9.

Модификация весов производится после предъявления каждой пары вход - выход. Однако если коэффициент η, определяющий скорость обучения, мал, то можно показать, что обобщенное дельта-правило достаточно хорошо аппроксимирует минимизацию общей ошибки функционирования сети D методом градиентного спуска в пространстве весов.

Общая ошибка функционирования сети определяется так:

D=0.5ΣΣ(0jp-djp)2;

Обучение продолжается до тех пор, пока ошибка не уменьшится до заданной величины. Эмпирические результаты свидетельствуют о том, что при малых η система находит достаточно хороший минимум D.

Один из основных недостатков алгоритма обратного распространения, однако, заключается в том, что во многих случаях для сходимости может потребоваться многократное (сотни раз) предъявление всей обучающей выборки. Повышения скорости обучения добиваются, например, использованием информации о второй производной D, увеличением η. В последнем случае избежать осцилляций позволяет инерционный член:

Δwij(t+1)=ηδjyi+αΔwij(t); (9)

где α - экспоненциально затухающий множитель, определяющий относительное воздействие текущего и прошлых градиентов на изменение веса.

Предпринимаются попытки использовать алгоритм обратного распространения ошибки для обучения сетей с обратными связями обработки последовательностей образов. Основой для этого является эквивалентность многослойной сети с прямыми связями и синхронной сети с обратными связями на ограниченном временном интервале (слой соответствует такту времени). Предложены также варианты алгоритмов обучения, более привлекательные с биологической точки зрения. Таким, например, является алгоритм рециркуляции, предложенный для сетей, в которых скрытые блоки соединены со входными. При обучении веса связей перестраиваются таким образом, чтобы минимизировать частоту смены активности каждого блока. Таким образом, обученная сеть имеет стабильные состояния и может функционировать в режиме ассоциативной памяти.

В настоящее время многослойные персептроны являются наиболее популярной моделью нейронных сетей. Это в значительной степени объясняется тем, что с их помощью удалось продемонстрировать решение ряда задач, в том числе классической для персептронов задачи «исключающего ИЛИ», задачи синтеза речи по тексту, а также задач, требующих принятия экспертных решений. Возможно, что подобные многослойным персептронам нейронные структуры используются мозгом для предварительной обработки сенсорной информации, например, при выделении признаков.

Сети с симметричными связями

1. Ансамблевые нейронные сети.

Минский и Пейперт отмечали, что недостатки простых персептронов можно преодолеть как с помощью многослойных сетей, так и введением в сеть обратных связей, допускающих циркуляцию сигналов по замкнутым контурам. Использовать свойства такого рода сетей для моделирования функций мозга еще в 1949 г. предложил Хебб.

Согласно взглядам Хебба нервные клетки мозга соединены друг с другом большим количеством прямых и обратных возбуждающих связей и образуют нейронную сеть. Каждый нейрон осуществляет пространственно-временную суммацию приходящих к нему сигналов от возбужденных нейронов, определяя потенциал на своей мембране. Когда потенциал на мембране превышает пороговое значение, нейрон возбуждается. Нейрон обладает рефрактерностью и усталостью. Эффективность связей может изменяться в процессе функционирования сети, повышаясь между одновременно возбужденными нейронами. Это приводит к объединению нейронов в клеточные ансамбли - группы клеток, которые чаще всего возбуждались вместе, и к обособлению ансамблей друг от друга. При возбуждении достаточной части ансамбля он возбуждается целиком. Различные ансамбли могут пересекаться: один и тот же нейрон может входить в разные ансамбли. Электрическая активность мозга обусловлена последовательным возбуждением отдельных ансамблей.

Идеи Хебба оказали большое воздействие на представления о работе мозга и послужили основой для создания нейронных моделей долговременной памяти. Действительно, ансамблевую нейронную сеть можно рассматривать как структуру, реализующую функции распределенной ассоциативной памяти. Формирование ансамблей в такой сети соответствует запоминанию образов (признаков, объектов, событий, понятий), закодированных паттерном активности нейронов, а сформированные ансамбли являются их внутренним представлением. Процесс возбуждения всего ансамбля при активации части его нейронов можно интерпретировать как извлечение запомненной информации по ее части - ключу памяти. Модель памяти на основе ансамблевой нейронной сети обладает некоторыми свойствами, присущими биологической памяти, такими, как ассоциативность, распределенность, параллельность, устойчивость к шуму и сбоям, надежность. Проводятся также структурные аналогии между ансамблевыми моделями нейронных сетей и строением коры головного мозга.

Имеются экспериментальные данные о синаптической пластичности, постулированной Хеббом.

Модель ансамблевой сети состоит из большого количества нейроподобных элементов, каждый из которых обычно соединен со всеми другими элементами сети. Входной образ подается на сеть путем активации нужных нейроподобных элементов. В отличие от персептрона ансамблевая сеть может обучаться как с учителем, так и без него. Обучение производится по правилу Хебба (5) или одному из его вариантов. Значение коэффициента α (5) при обучении с учителем определяет величину подкрепления, а при обучении без учителя эта величина может быть установлена, например, постоянной. Отметим, что правило Хебба (5) формирует симметричную матрицу связей.

В процессе обучения при подаче на сеть набора входных образов - представителей среды - в сети формируются ансамбли, которые могут иметь сложную структуру, отражающую свойства среды. Действительно, связность внутри групп нейроподобных элементов, которые наиболее часто возбуждались одновременно, будем значительно выше, чем в среднем по сети. Так образуются ядра ансамблей, в которых накапливаются комбинации признаков, наиболее часто встречающиеся во входных образах. Их можно рассматривать как внутреннее представление образов-прототипов классов, объективно существующих во внешней среде. Более редкие комбинации возбужденных нейроподобных элементов образуют бахрому ансамблей, где фиксируются индивидуальные особенности образов, внутренний и внешний контексты и т. д.

Количество образов, которое можно запомнить в сети, сильно зависит от их размера, т. е. от количества нейроподобных элементов, которое активизируется образом, а также от степени корреляции образов. Аналитически и экспериментально показано, что количество стохастических образов, которое можно запомнить и восстановить в ансамблевой сети, при малом размере образа может значительно превышать число нейроподобных элементов сети.

При подаче на обученную ансамблевую сеть некоторого входного образа путем установки начального паттерна активности осуществляется восстановление наиболее близкого к нему образа из числа запомненных в сети. Сеть представляют самой себе, и в ней начинается обычный процесс (синхронный или асинхронный - в зависимости от используемого алгоритма) изменения состояний нейроподобных элементов. При этом из-за наличия только возбуждающих связей возникает проблема регулирования уровня активности сети, т. е. количества одновременно активных элементов. Для ее решения был предложен ряд внутрисетевых и внешних механизмов. Если уровень активности сети поддерживается примерно равным величине ансамбля, то межансамблевая конкуренция приводит к релаксации сети из начального к конечному устойчивому состоянию, соответствующему запомненному образу.

В ряде работ теоретически и экспериментально исследуются количественные характеристики функционирования ансамблевых сетей, например качество воспроизведения образа в зависимости от числа запомненных в сети образов и их размера, а также от степени близости к ним входного образа и т. д. Интересный метод аналитического исследования сетей с обратными связями предложен Хопфилдом.

2. Сеть Хопфилда.

Хотя многочисленные результаты моделирования демонстрировали стабильность ансамблевых сетей с обратными связями и хеббовским правилом обучения (эволюцию сети к устойчивому состоянию), отсутствие математического обоснования такого введения препятствовало их популярности. Положение изменилось с появлением работ, где было определено подмножество нейронных сетей с обратными связями, которые гарантированно достигают устойчивого состояния.

В 1982 г. американский биофизик Джон Хопфилд опубликовал статью [134], где на основании аналогии между нейронными сетями и особым классом физических систем - спиновыми стеклами - ему удалось привлечь к анализу нейросетевых моделей мощный математический аппарат статистической физики. Это стимулировало вторжение в область моделирования нейронных сетей большого отряда ученых-физиков, которыми в настоящее время получено много интересных аналитических результатов.

Сам Хопфилд в упомянутой статье рассмотрел поведение модели полносвязной сети бинарных нейроподобных элементов с симметричными связями (wij = wji). Элементы функционировали в асинхронном режиме, т. е. каждый нейрон в случайные моменты времени с некоторой средней частотой определял свое состояние в соответствии с правилом (3).

Это позволило описать поведение сети как релаксационный процесс, при котором минимизируется энергетическая функция Е (функция Ляпунова, гамильтониан) модели:

E=-0.5ΣΣwijyiyj+Σθiyi; (10)

где wij - матрица связей; у и θ - состояние и порог модельного нейрона. Действительно, изменение Е при изменении состояния нейрона (учитывая симметрию wij и полагая θ=0)

ΔE=-ΔyiΣwijyj; (11)

Так как знак Δyi совпадает со знаком Σwijyj, ясно, что Е по мере срабатывания нейронов будет монотонно убывать, а так как Е ограничена, будет достигнуто состояние ее минимума. Таким образом, эволюция сети из любого начального состояния приводит к состоянию, соответствующему локальному минимуму Е. Можно провести аналогию поведения сети с движением легкой частицы по некоторому вязкому рельефу под действием силы тяжести.

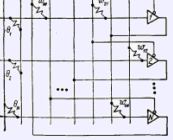

В своей работе Хопфилд исследовал сеть с нейроподобными элементами, имеющими сигмоидную характеристику. Состояния нейронов такой сети изменяются одновременно и непрерывно, и сеть описывается системой дифференциальных уравнений. Хопфилд доказал сходимость и такой сети к стабильным энергетическим минимумам и нашел соответствие между ее устойчивыми состояниями и устойчивыми состояниями сети с бинарными элементами. Это послужило основой для построения аппаратных моделей, где сеть реализуется как аналоговая электронная схема, состоящая из операционных усилителей, моделирующих нейроны, соединенных резисторами с проводимостями wij, и со смещениями входными токами θ (см. рисунок).

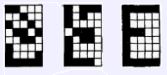

Понятно, что если сделать минимумами энергии заданный набор паттернов нейронной активности (образов), оба варианта сети Хопфилда смогут выполнять функции ассоциативной памяти, «скатываясь» к тому образу, в чей «бассейн притяжения» попадает начальный паттерн активности нейронов сети. Например, на рисунке показано восстановление сетью из 40 нейронов, которые расположены в виде матрицы 5х8, запомненного в сети изображения буквы «Е». Активному нейрону соответствует заштрихованный элемент изображения. Из поданного на сеть зашумленного изображения (слева) восстанавливается правильное изображение (справа).

Как и следовало ожидать, одним из способов получения нужной энергетической функции является формирование матрицы связей в соответствии с вариантом хеббовского правила:

wijΣ(2zip-1)(2zjp-1); (12)

где:

zp - образы, которые надо запомнить в сети;

L - их количество.

Это правило, как и правило, предложенное Хеббом, обеспечивает формирование симметричной матрицы связей, однако постулирует увеличение веса связей между не только одновременно активными, но и одновременно неактивными нейронами, а также его уменьшение между нейронами, находящимися в разном состоянии. Такое правило допускает существование тормозящих модифицируемых связей между нейронами и даже переход возбуждающих связей в тормозящие. Оно позволяет сети автоматически саморегулировать уровень активности и работать с нулевыми порогами нейронов. Однако при этом значительно снижается емкость памяти сети: количество случайных образов, которое можно записать в сеть с возможностью восстановления, не превышает 0.14 количества нейронов. Кроме того, в дополнение к энергетическим минимумам, соответствующим запомненным образам, возникают ложные минимумы функции Е. Положение еще более осложняется для скоррелированных образов, которые после запоминания не становятся минимумами Е.

В настоящее время ведется интенсивная работа по улучшению характеристик модели Хопфилда, предлагаются ее интересные расширения и обобщения. Предпринимаются попытки создать алгоритмы обучения, позволяющие работать со скоррелированньми образами. В ряде работ приводятся обучающие правила, осуществляющие ортогонализацию и позволяющие запоминать в матрице связей произвольный набор линейно независимых образов. Такие правила, однако, приводят к усложненной нелокальной зависимости матрицы связей от записываемых образов. Предлагаются способы отражения иерархии скоррелированных образов, существующей в реальном мире, в иерархическом дереве устойчивых состояний нейронной сети.

В ряде работ дан анализ появления в сети Хопфилда ложных образов. Они возникают вследствие присущего нейронной сети свойства накапливать в процессе обучения наиболее часто встречающиеся комбинации входных сигналов, формируя прототипные образы. Однако это свойство, очень полезное для ансамблевых сетей с малым уровнем активности, для сети Хопфилда приводит к отрицательному эффекту из-за большого уровня активности используемых в ней образов, а следовательно, значительного их перекрытия.

Предпринимаются поиски способов увеличения количества образов, которое можно запомнить в сети Хопфилда. Предлагалось ввести в модель «забывание» (например, ограничением величины весов). При этом новые записываемые в сеть образы будут вытеснять старые. Можно добиться увеличения числа запомненных образов ценой введения множественных связей. Однако радикального улучшения информационных характеристик сети Хопфилда, как показывает анализ, позволяет добиться первоначальный вариант хеббовского правила в сети с низким уровнем активности. Это подтверждается также данными исследователей, работающих с ансамблевыми сетями.

Интересным результатом увенчалась работа по преодолению таких серьезных с биологической точки ограничений модели, как полносвязность и симметрия. Оказалось, что сильно разреженная асимметричная версия сети Хопфилда может быть решена аналитически, и ее поведение качественно похоже на поведение полносвязной сети в области хорошего восстановления.

Для сети Хопфилда предложен также ряд механизмов работы с последовательностями. Основная проблема заключается в том, чтобы при запоминании отразить в статической структуре матрицы связей порядок следования входных образов, а при воспроизведении обеспечить их восстановление в нужном порядке. Это достигается формированием матрицы связей, в которой наряду со стационарными состояниями (симметричные связи) запомнены переходы между ними (асимметричные связи от предшествующего образа к последующему). Для того чтобы разделить два типа динамики - релаксацию к устойчивому состоянию, соответствующему одному из образов последовательности, и переход к следующему образу- было предложено записывать переходы между состояниями в отдельной матрице связей и ввести временные задержки на сигналы, поступающие на входы нейронов через эту матрицу. Вследствие этого сеть сначала стабилизируется в некотором состоянии, а уже потом начинает «ощущать» притягивающее влияние следующего состояния и переходит в него.

На таких сетях была продемонстрирована генерация, распознавание и подсчет элементов простейших последовательностей, однако пока не решена проблема обработки более сложных последовательностей, имеющих общие части, разветвления и повторения.

Развивая свои идеи о «коллективных вычислениях» в нейронных сетях, Хопфилд предложил использовать свойство сети минимизировать энергетическую функцию для решения оптимизационных задач. С этой целью сначала выбирается «нейронное» представление для конкретной задачи, т. е. исходя из ее условий состоянию нейронов присваивается смысл. Затем с учетом ограничений, налагаемых на задачу, конструируется энергетическая функция таким образом, чтобы в состояниях, представляющих возможные решения, она была пропорциональна стоимостной функции задачи. После этого из энергетической функции извлекаются связи wij и пороги θi, и конструируется соответствующая сеть.

Так как в процессе функционирования сеть минимизирует свою энергию, динамика в пространстве состояний направлена на минимизацию соответствующей стоимостной функции. Поиск минимума энергии занимает всего несколько постоянных времени нейронов, поэтому сеть быстро достигает стабильного состояния, из которого декодируется решение задачи.

Так как здесь в отличие от задачи ассоциативной памяти требуется нахождение не локального, а глобального энергетического минимума, существенной оказывается сигмоидность характеристик нейронов (бинарные нейроны здесь не подходят) и аналоговый характер их взаимодействия. Решения, находимые такой аналоговой сетью, не самые лучшие, но достаточно близки к ним.

Несмотря на недостатки сети Хопфилда, предпринимаются попытки использовать ее аппаратные реализации для решения задач, требующих быстрого распознавания небольшого количества простых образов.

3. Машина Больцмана.

Машина Больцмана представляет собой стохастический вариант сети Хопфилда. Бинарные нейроподобные элементы (блоки) трактуются здесь как представители элементарных гипотез, а веса - как слабые парные взаимоограничения между ними. Положительный вес связи указывает, что две гипотезы стремятся поддерживать друг друга, а отрицательный - на их несовместимость.

Симметрия связей позволяет проанализировать поведение сети с использованием энергетической функции:

E=-0.5ΣΣwijyiyj+Σθiyi; (13)

Энергию определенного паттерна активности можно интерпретировать как степень нарушения ограничений, присутствующих в проблемной области, со стороны конкретной комбинации гипотез или как стоимостную функцию, которая должна быть минимизирована для решения оптимизационной задачи.

Если зафиксировать состояния некоторых блоков, подав, таким образом, на сеть входное воздействие, остальные блоки начнут изменять свое состояние так, чтобы минимизировать энергию Е. Действительно, поступающая на каждый блок взвешенная сумма сигналов от активных блоков из-за симметрии связей совпадает с величиной разности между значениями, энергетической функции, зависящей от его собственного состояния:

Si=Σwijyj-Θi=Eiвыкл-Eiвыкл; (14)

Поэтому алгоритм изменения состояния бинарных нейроподобных элементов автоматически приводит к минимизации энергии Е.

При этом, однако, сеть может попасть в локальный минимум, что крайне нежелательно для оптимизационных задач. Чтобы сеть могла выбраться из локального энергетического минимума, в машине Больцмана применяется вероятностное правило срабатывания блоков:

Pi=P(ΔEi)=1/(1+e-ΔEi/T); (15)

где:

рi - вероятность нахождения i-ro блока в единичном состоянии;

Р(х) - сигмоидная функция;

T - параметр, аналогичный температуре.

При Т → 0 это правило переходит в правило срабатывания детерминированных бинарных элементов (3), а при повышении температуры увеличивается вероятность перехода системы в состояние с большей энергией.

Если сеть с таким вероятностным правилом придет в состояние «теплового равновесия», относительные вероятности ее нахождения в двух глобальных состояниях будут подчиняться распределению Больцмана

PA/PB=e-(EA-EB)/T; (16)

где:

РA - вероятность нахождения сети в глобальном состоянии A;

ЕA - его энергия.

При низкой температуре система «предпочитает» состояния с низкой энергией, однако требуется много времени для достижения равновесия. При высоких температурах равновесие достигается быстрее, однако нет сильного предпочтения низким энергетическим состояниям.

Хороший способ нахождения глобального минимума получил название «имитация отжига» из-за аналогии с медленным охлаждением металла для получения низкоэнергетической кристаллической решетки. При этом сначала в сети устанавливают высокую температуру, при которой ее поведение почти случайно, а затем постепенно понижают температуру со скоростью, которая гарантирует, что система всегда будет близка к тепловому равновесию и не попадет в локальный минимум. При высокой температуре- сеть быстро находит зону энергетического ландшафта, где находится хороший минимум. При снижении температуры сеть находит в этой зоне близкий к глобальному минимум энергии.

Машина Больцмана может использоваться для классификации образов. При этом в ней, как и в многослойном персептроне, выделяют входные, выходные и внутренние (скрытые) блоки, однако для каждой прямой связи между блоками существует равная ей по величине обратная (симметричная) связь. Процесс распознавания состоит из следующих шагов:

- на входных блоках фиксируют входной образ;

- рандомизируют состояние скрытых и выходных блоков, а затем медленно понижают температуру;

- наблюдают за состоянием сети при конечной низкой температуре и собирают статистику состояний выходных блоков.

На основании этой статистики делают вывод о входном образе.

Для машины Больцмана существует алгоритм обучения, который, как и для многослойного персептрона, создает путем модификации связей внутреннюю модель среды, позволяющую достаточно хорошо классифицировать входные образы. Для работы алгоритма требуется обучающая выборка, состоящая из пар вход - выход, которые должна научиться ассоциировать сеть. Если после обучения зафиксировать на входных блоках один из входных образов, на выходных блоках должен появиться соответствующий выходной образ. Если подать на вход неизвестный образ, система на основе выявленных в обучающей выборке закономерностей должна провести правильное обобщение.

Практически каждый цикл обучения состоит из трех шагов.

1. Фаза тренировки. Для каждой пары образов фиксируются состояния входных и выходных блоков, а остальная часть сети подвергается отжигу к низкой температуре. Затем для каждой связи собирается статистика, какую часть времени pij+ были одновременно активны соединяемые ею блоки.

2. Фаза проверки. Вычисляется аналогичная величина pij-, однако теперь выходные блоки не зафиксированы и свободно меняют состояние.

3. Изменение связей. В хорошо обученной сети ее поведение будет идентично для обеих фаз. Если р+ и р- не совпадают для конкретной связи, ее изменяют:

Δij=ε(pij+-pij+); (17)

где:

ε - масштабирует размер изменения.

Q=ΣP+(Ia^Ob)*ln(P+(Ob|Ia)/P-(Ob|Ia)); (18)

где:

P+(Ia и Ob) - вероятность а-го состояния входных блоков и b-го состояния выходных, когда они фиксированы внешней средой;

P+(Ia или Ob) - вероятность b-го состояния выходных блоков при а-м состоянии входных, когда они фиксированы средой;

Р-(Оb или Ia) - соответствующая вероятность, когда фиксированы только входы.

Действительно, частная производная Q по каждому из весов имеет вид:

δQ/δwij=-(1/T)(Pij+-Pij+); (19)

что позволяет обучать сеть с помощью описанной локальной процедуры.

К сожалению, алгоритм обучения машины Больцмана имеет типичные недостатки, присущие процедурам градиентного спуска в многопараметрических пространствах. Прежде всего это неточность вычисления градиента, обусловленная неполным достижением теплового равновесия и ограниченным временем сбора статистик. Из-за своей стохастичности алгоритм требует гораздо больших временных затрат по сравнению даже с алгоритмом обучения многослойного персептрона методом обратного распространения ошибки. Имеющаяся аппаратная реализация, однако, смягчает этот недостаток по крайней мере для небольших сетей. Известны примеры применения машины Больцмана для решения классических персептронных задач, таких, как задача «исключающего ИЛИ», обнаружение симметрии во входном образе и т. д., а также для распознавания речи.

Литература

- Нейрокомпьютеры и интеллектуальные роботы. Под ред. Н.М. Амосова, Киев, Наукова думка, 1991.

- В.Д. Цыганков. Нейрокомпьютер и его применение. М., СолСистем, 1993.

- Е.Н. Соколов, Г.Г. Вайткявичус. Нейроинтеллект от нейрона к нейрокомпьютеру. М., Наука, 1989.

- Отчет о НИР «Принципы представления знаний в системах управления роботов». Под руководством Н.М. Амосова, Киев, 1985.

- Ю.В. Чернухин. Микропроцессорное и нейрокомпьютерное управление адаптивными мобильными роботами. Таганрог, 1993.

- Ю.В. Чернухин. Нейропроцессоры. Таганрог, 1994.

- Труды третьего международного симпозиума «Интеллектуальные системы», Псков, 1998.

- В.Ф. Венда. Системы гибридного интеллекта. М., Машиностроение, 1990

- Л.И. Волгин. Комплиментарная алгебра нейросетей. Таллин, АО KLTK, 1993.

Источник: (Искусственный разум)

Дополнительно

Ключевые слова: Нейронные сети, Нейрон

Скачать